9月下旬のAI関連ニュース。。今週もインパクトのある発表ばかり。。

ルカン氏がAIについて言及

AIマフィアのルカン氏がAIについて言及。数年以内に人間の知能を匹敵するようになるとのこと。

It’s important to project ourselves into the future and imagine what the future is going to be and then work towards making that future the best possible. So the way that technology, I’m a scientist, so I try to envision where technology is going and what is going to be made possible. We’re going to have systems, within some number of years, it’s very difficult to tell exactly when, the systems that match human intelligence in all respects or surpass it in many respects. So this is going to be a situation where every one of us is going to be empowered by a team of staff of AI assistants working for us, essentially. It’s going to be true for anyone who can access the internet, essentially. How are those systems going to be accessed? They’re not necessarily going to be accessed through smartphones. The future of hardware is going to be things like smart glasses, which can see what you see, can you hear what you hear, can remember what you don’t remember and helps you remember it, can answer any question you have. So it’s like having a human staff working for you at all times. And those systems will have displays. So this kind of devices are coming up, within the next year or two. And what that enables is interaction between people in their own language, for example. So we already have prototype systems that can translate hundreds of languages in any direction.

自分自身を未来に投影し、未来がどうなるかを想像し、その未来を最高のものにするために努力することが重要なんだ。私は科学者なので、テクノロジーがどこに向かっているのか、何が可能になるのかを想像しようとします。何年か以内には、人間の知能にあらゆる点で匹敵するか、多くの点でそれを上回るようなシステムが誕生するでしょう。つまり、私たち一人ひとりが、基本的に私たちのために働くAIアシスタントのスタッフチームによって力を与えられるような状況になるのです。インターネットにアクセスできる人であれば、基本的に誰でもそうなるだろう。これらのシステムにはどのようにアクセスするのか?スマートフォンからアクセスするとは限らない。ハードウェアの未来は、スマートグラスのようなものになるでしょう。スマートグラスは、あなたが見ているものを見ることができ、あなたが聞いているものを聞くことができ、あなたが覚えていないことを記憶し、あなたがそれを思い出すのを助け、あなたが持っているどんな質問にも答えることができます。つまり、人間のスタッフが常にあなたのために働いているようなものです。そのようなシステムにはディスプレイがあります。このようなデバイスは、今後1、2年のうちに登場するでしょう。それによって可能になるのは、例えば母国語での対話です。私たちはすでに、何百もの言語を縦横無尽に翻訳できるシステムのプロトタイプを持っています。

DeepL.com(無料版)で翻訳しました。

Molmo

アレン人工知能研究所が新たなマルチモーダルAI「Molmo」をオープンソースでリリースしました。

Open AIのChatGPT-4o、Gemini 1.5 Proに匹敵する精度とのこと。。なんてこった。

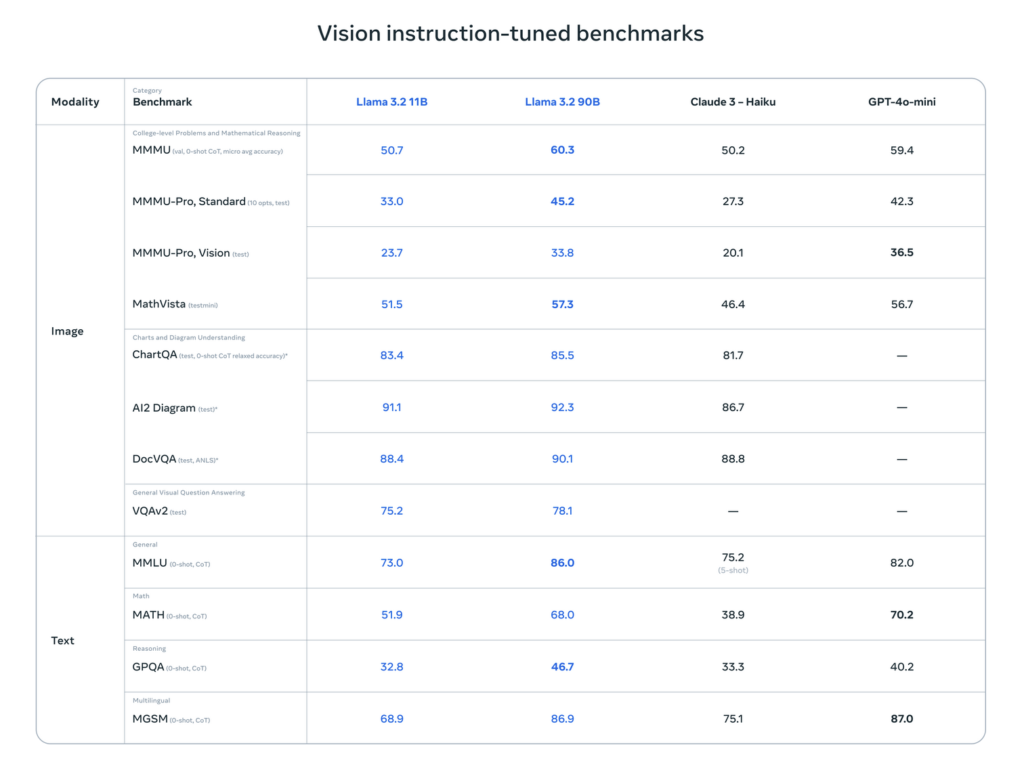

Llama3.2リリース

日付:2024年9月25日

Meta社Llama3.2がリリース。GPT-4pminiには及ばないか。

Googleより最新AIバージョンをリリース

日付:2024年9月24日

Googleが生成AIであるGemini 1.5シリーズを更新し、Gemini-1.5-Pro-002とGemini-1.5-Flash-002をリリース。更新ポイントは以下の通り。

・1.5 Pro でのプロンプト(<128K)の入出力の両方で、価格を50%以上削減

・1.5 Flash で2倍、1.5 Pro で約3倍のレート制限の引き上げ出力速度が2倍速く、遅延が3分の1

・デフォルトのフィルター設定を更新

LLM-jpより新LLMリリース

日付:2024.09.25

国立情報学研究所よりオープンなLLMモデルがリリースされました。

精度比較検証結果がないので、実力は不明です。。頑張れ国家プロジェクト。。

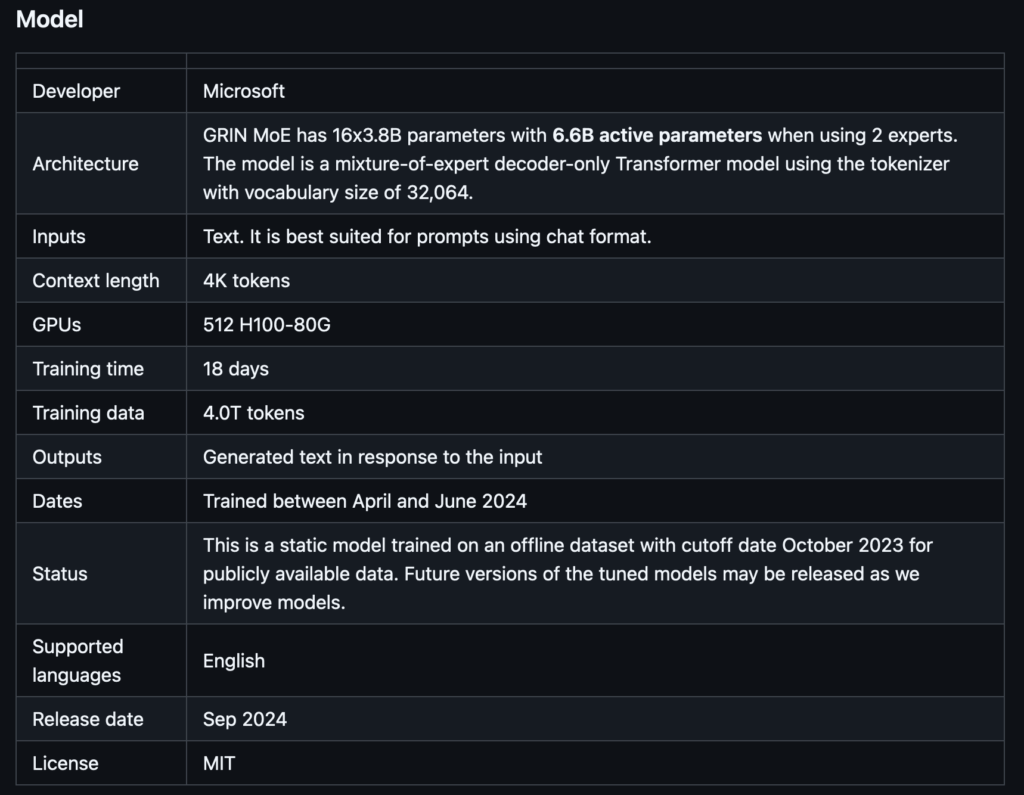

GRIN MoE

Microsoft社から66億パラメータのモデルがリリース。

o1によるAIは推論者(Reasoning)に到達

OpenAIのSam Altmanがo1について語っており、AIの第二段階に入ったとのこと。

AIの段階は下記の通り。

第一段階:Chatbots

第二段階:Reasoners

第三段階:Agents

第四段階:Innovators

第五段階:Organizations

I think of this as we’re at the GPT2-stage of these new reasoning models and you will see it, over the coming year to the GPT-4 equivalent.

But even in the coming months, you’ll see it got a lot better as we move from o1-preview to o1, which we shared some metrics for in our launch blog post.It’s a very significant step forward and I think one of the many fun things about is that the curve, the improvement curve, is really steep. And so, things that the models can’t solve right now in a few months will be able to solve, a few months after that, be able to solve even more.

And most importantly, I don’t know about most importantly, importantly, I think we’re going to see a whole new set of ways to use these models. When we had GPT-3.5, it was in the API for a while and then it was really the ChatGPT moment that made people use it a lot. And even then it took people a while to figure out how to use ChatGPT and it took us a while to build all the other features and add the things that people wanted. So I think we’re that early with o1. There will be totally new ways to use it that are not just a chat inteferface. It’ll take us a while to bulid those and other people a while to build those. It’ll also take users a while to figure out how to use it. And this pretty different than the GPT models. We have these five levels of AI we talk about. The first was chatbots, The second, which we’ve just reached now, is reasoners. The third is agents. The fourth is innovators: the ability to figure out new scientific information, and the fifth is full organization. So this move from one to two took a while. But I think the most exciting, one of the most exciting things about two is that it enables level three relatively quickly after and the agentic experiences that we expect this technology to eventually enable, I think will be quite impactful.日本語訳

この新しい推論者モデルはGPT2の段階にあり、今後1年かけてGPT-4に相当するところまで到達すると思います。

しかし、今後数ヶ月の間でも、o1-previewからo1に移行するにつれて、かなり良くなっているのがわかるでしょう。そして、今モデルが解決できないことも、数ヵ月後には解決できるようになり、その数ヵ月後にはさらに解決できるようになる。

そして最も重要なことは、最も重要なことなのかどうかわからないが、重要なことは、これらのモデルを使用するまったく新しい方法を目にすることになるだろうということだ。GPT-3.5を開発したとき、しばらくはAPIにあったんですが、ChatGPTがきっかけで多くの人が使うようになりました。そして、ChatGPTの使い方を理解するのに時間がかかり、他のすべての機能を構築し、人々が望むものを追加するのに時間がかかりました。だから、o1ではそのくらい早い段階だと思う。単なるチャットインターフェイスではない、まったく新しい使い方ができるでしょう。それを構築するには、僕らも他の人たちも時間がかかるだろう。 また、ユーザーが使い方を理解するのにも時間がかかるだろう。これはGPTのモデルとはかなり異なります。私たちは5段階のAIについて話しています。1つ目はチャットボット、2つ目は現在到達したばかりの推論者、3つ目はエージェントです。4番目はイノベーターで、新しい科学的情報を理解する能力、そして5番目は完全な組織化です。1つ目から2つ目への移行には時間がかかりました。そして、このテクノロジーが最終的に可能にすると思われるエージェント的な体験は、かなりインパクトのあるものになると思います。

Parables on the Power of Planning in AI: From Poker to Diplomacy: Noam Brown (OpenAI)

Open AIでo1の開発プロジェクトに携わっているノーム・ブラウン氏の講演内容が公開されました。

ELYZA社のGENIAC成果発表

ELYZA社のGENIAC成果発表資料。

Llama3ベースでLlama-3ELYZA-JP-8BとLlama-3-ELYZA-JP-70Bを開発。

Llama-3ELYZA-JP-8Bは商用利用可能な形で一般公開、Llama-3-ELYZA-JP-70Bはデモサイトで公開。70BモデルのほうはGPT-4に上回るスコアを達成、8BモデルはGPT-3.5 Turboに匹敵とのこと。